El aprendizaje, en general, está íntimamente relacionado con la compresión de datos observados, de resultados de experimentos o de observación de comportamientos. Se puede afirmar que si un estudiante simplemente memoriza una serie de ejemplos, uno tras otro, no aprende. Si después de leer un libro nos preguntan de qué se trató, podemos elegir con cuánto detalle contar la historia, es decir, presentar el libro con distintos grados de compresión.

Compresión y ciencia

Se podría decir que la ciencia es el arte de la compresión de datos. El científico observa múltiples experimentos e intenta representar alguna propiedad de manera breve, un patrón que se repite, eliminando así el ruido de alguna esencia de interés en los datos. Por ejemplo, al observar una y otra vez el lanzamiento de balas de cañón de distintas formas y tamaños, el científico no recuerda las decenas de experimentos con sus pequeñas variaciones, sino que comprime toda esta información en una ley que describe el movimiento como si fuera el de un punto que se mueve siguiendo la forma de una parábola, y que está descrita mediante una ecuación matemática. De forma similar, un niño no aprende a hablar un idioma memorizando cientos de oraciones, sino que de alguna manera las va comprimiendo todas en reglas y patrones que le permiten entender el lenguaje e inclusive hablarlo, generando nuevas oraciones que nunca había escuchado.

Compresión en animales

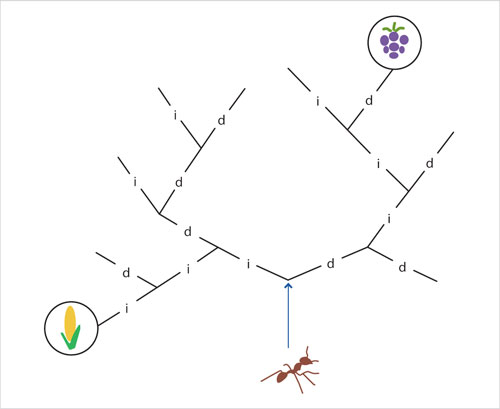

De igual manera, la naturaleza, siempre sabia, utiliza la compresión. Experimentos con hormigas, como los descritos por Li y Vitanyi, muestran que éstas comprimen los datos de los caminos que van recorriendo, es decir, aprenden qué caminos llevan a lugares con comida, y comunican esta información a otras hormigas. En un experimento, se coloca comida en algunas de las hojas de un árbol binario y en otras no.

Curiosidades

Muchos sistemas de compresión de datos pierden información, con el objetivo de lograr comprimir aún más la entrada dada. Esto es común en compresión de audio o video, ya que la mente humana no percibe pequeñas distorsiones en este tipo de medios. Por ejemplo, es posible comprimir audio 10 veces sin que el oído lo note, y comprimir video 300 veces con muy poca pérdida visual. Para imágenes fotográficas es común usar el estándar jpeg y para audio y video el estándar mpeg.

Curiosidades

A lo largo de la historia el hombre se ha preguntado cómo se pasa la información hereditaria de una generación a otra. En 1953, James Watson y Francis Crick descubrieron la estructura y propiedades del ADN, la molécula que lleva esta información. Descubrieron que las características de un ser humano están codificadas en una larga cadena de ácidos nucleícos, arreglada en una doble hélice, como si fuera una escalera de cuerda trenzada con tres mil millones de peldaños, que se pueden representar por cadenas de cuatro letras, A, T, C y G, lo que les mereció el Premio Nobel en 1962. En 1968, Nirenberg, Khorana y Holley recibieron el Premio Nobel (con la contribución de otros científicos) por descifrar el código de la vida: el ADN representa un vocabulario de palabras de 20 letras.

Se observó que a las hormigas les toma más tiempo comunicar patrones de caminos más "aleatorios" que más "regulares". El camino que lleva al elote es fácil de aprender, ya que consiste solamente en tomar bifurcaciones a la izquierda, mientras que el camino hacia las uvas "diid" es menos regular.

Compresión y aprendizaje

Cada camino que recorre una hormiga se puede representar mediante una secuencia de bits. Algunos caminos son muy fáciles de aprender, por más largos que sean. Por ejemplo, el camino "010101010101010101010101010101" se aprende fácilmente, ya que simplemente se describe como "cada vez que encuentres una bifurcación, toma el camino de la izquierda o el de la derecha, alternadamente". Mientras que en el caso de otros caminos, como "010010001111010001110101000010", que no siguen ningún patrón aparente, debe aprenderse de memoria una secuencia entera de bits. En realidad, la dificultad no tiene que ver con la aleatoriedad del camino tal cual, ya que si se decidiera con una moneda cada uno de los bits de la secuencia, ambas secuencias tienen exactamente la misma probabilidad de ocurrir. La dificultad está relacionada, de alguna manera, con la cantidad de información en el camino. Se verá más acerca de la medición de la información más adelante.

Una manera de precisar qué quiere decir exactamente que un camino sea más fácil o difícil de aprender es usando la llamada Complejidad de Kolmogorov, que indica cuál sería el programa de computadora más pequeño que podría producir la secuencia. Es decir, esta teoría permite estudiar qué tanto es posible comprimir una cadena de bits.

En general, los computólogos han estudiado mucho el aprendizaje, desde diversos puntos de vista, y el área de aprendizaje en computación tiene muchas aplicaciones: los sistemas de compras en internet se adaptan a los gustos de los usuarios, los programas para jugar ajedrez aprenden las estrategias del oponente, los programas que reconocen la voz (y la escritura) se adaptan al estilo de una persona y cometen menos errores mientras más la escuchan, los robots aprenden acerca del ambiente donde se mueven, los programas para diagnósticos médicos aprenden de la experiencia, los algoritmos para finanzas y la bolsa de valores, etcétera.

Expansión. Representaciones para garantizar integridad

En ocasiones es útil expandir los datos, en lugar de comprimirlos, con el fin de introducir redundancias que permitan detectar y hasta corregir errores. Esto se hace tanto en computadoras como en la naturaleza.